Полезен или вреден искусственный интеллект? Этот вопрос в последние несколько месяцев волнует не только представителей IT-индустрии, но и широкую общественность. Таблоиды пестрят заголовками о потенциальной угрозе ИИ для человечества. Насколько опасно развитие ИИ-технологий? Сколько осталось времени у человечества до появления суперинтеллекта? Почему ученые и бизнесмены из IT-индустрии хотят приостановить развитие ИИ-технологий? О технологических тенденциях и их последствиях — в интервью «Коммерсанта UK» с Валерием Аджиевым, главным научным сотрудником Национального центра компьютерной анимации при Университете Борнмута.

— В последние месяцы тема использования искусственного интеллекта (artificial intelligence, AI) стала одной из самых популярных. Что такое искусственный интеллект в принципе?

— Обычные компьютерные системы — это, по сути, калькуляторы, только чрезвычайно мощные. Они решают задачи, точно реализуя заложенный в них программистами алгоритм, который расписывает вычислительный процесс по шагам. Системы искусственного интеллекта способны сами в той или иной степени вырабатывать алгоритм решения поставленной задачи после обучения на больших массивах данных. При этом роль человека остается определяющей, потому что именно программисты задают так называемую архитектуру конкретной ИИ-системы (она может быть разной), а также правила игры, которые формулируют суть решаемой задачи. На обывательском уровне критерий для выделения ИИ-систем — может ли она сама, подобно человеку, решать творческие задачи или даже мыслить? На заре развития компьютерных технологий Алан Тьюринг придумал такой способ определить, умеет ли машина мыслить: если невозможно отличить генерируемые ответы на вопросы от тех, которые бы дал человек, то можно сказать, что машина обладает интеллектом. Современные программы тест Тьюринга, пусть и для специфических диалогов, проходят. Но сейчас его ассоциируют с традиционными ИИ, которые решают узкоспециализированные задачи, автоматизируя рутинную деятельность человека (например, автоматический переводчик текста). Затем появилось понятие «обобщенный ИИ» (artificial general intelligence, AGI), который не только неотличим в диалоге от человека, но и успешно решает достаточно общие, не сводящиеся к одной узкой цели проблемы (раньше это было прерогативой человека). Он не просто обрабатывает информацию, а в определенной степени понимает ее смысл (например, виртуальный помощник-секретарь с широким набором обязанностей). Это нынешний этап развития ИИ, которое еще далеко до завершения. Наконец, специалисты начали говорить о следующем поколении — суперинтеллекте (superintelligence). Такой ИИ сможет в значительной степени заменить (или даже превзойти) человека в определенных видах деятельности — по мнению специалистов, это может случиться через десять лет.

— Чем обусловлено резкое повышение интереса к ИИ?

— ИИ — это достаточно обширная область компьютерных наук и технологий, но именно в последние 10–15 лет стал явным прогресс в направлении, связанном с машинным обучением (machine learning, ML) и так называемым глубоким обучением (deep learning, DL), суть которого заключается в использовании многослойных нейронных сетей, функционирующих примерно как человеческий мозг. В процессе обучения на больших объемах данных происходит настройка нейронов в сети, и в итоге она становится способна обрабатывать новые данные и генерировать решение проблемы. Этот прорыв получил хорошее освещение. Например, британская фирма DeepMind (позднее ее приобрел Google) создала шахматную программу AlphaZero. В отличие от других шахматных программ, она может играть как человек (только лучше) — не просто пересчитывая соперника, а генерируя глубокие стратегические идеи, причем вполне творчески. Для обучения реальные партии не использовались: ИИ играл по заложенным правилам сам с собой и корректировал изначально заданные параметры в зависимости от исхода отдельных партий. Сейчас ведущие шахматисты адаптируют приемы этой ИИ-программы к своей игре. А в последний год произошел крупнейший прорыв: в открытом доступе появились программы генеративного ИИ (generative AI), способные генерировать различный оригинальный контент — текстовый, изобразительный, музыкальный и т. д. Такие инструменты, как Midjourney, Stable Diffusion, DALL-E2, сразу приобрели большую популярность. Сейчас их используют в том числе и в индустрии компьютерной анимации и игр. Раньше подобные инструменты (менее мощные) были доступны только специалистам, а теперь и простые люди получили возможность поэкспериментировать с ними, и именно это создало принципиально новую ситуацию по отношению к ИИ.

— С появлением ChatGPT все заговорили о чат-ботах. Почему?

— Появление в открытом доступе ChatGPT — продукта американской компании OpenAI — действительно стало резонансным (хотя у него есть аналоги, например Google Bard). Это чат-бот, использующий большую языковую модель (large language model, LLM), обученный и продолжающий обучаться на огромных массивах данных (объем — 570 гигабайт), благодаря чему в его лексикон вошло 300 млрд слов из разных источников, относящихся к широкому спектру деятельности. Он способен не только вести вполне осмысленный диалог (давая «этичные» ответы на практически любые вопросы), но и генерировать различный оригинальный контент, писать резюме, статьи, рефераты, стихи, сценарии, проводить юридический и финансовый анализ, выдавая рекомендации, и т. д. Он уже работает как встроенное приложение с сервисами многих компаний — системами бронирования, доставки еды, маркетплейсами. Это самая быстрорастущая платформа (у нее есть бесплатная и более продвинутая платная версия) в истории компьютерных технологий с точки зрения количества пользователей. ChatGPT, реализованный на основе нейронной архитектуры GPT в версии 3.5, появился в открытом доступе в ноябре 2022 года, и уже в апреле 2023 года количество активных пользователей составило 173 млн, а количество посещений платформы — 1,8 млрд. В марте вышла версия ChatGPT 4 на основе усовершенствованной архитектуры GPT 4, которая может воспринимать не только тексты, но и изображения (правда, результаты пока выдает только в текстовом формате). Новости о достижениях платформы появлялись чуть ли не ежедневно: чат-бот создает полноценный сайт на основе нарисованного вручную макета, заполняет налоговые декларации, сдает экзамены в учебные заведения, включая профессиональный тест для работы практикующим адвокатом. Более того, он способен ориентироваться в ситуациях, требующих учета эмоциональных факторов. Такой стремительный прогресс в развитии ИИ-инструмента привел к тому, что люди стали задумываться: а куда этот прогресс может их завести?

— Действительно ли ИИ несет опасности? И какие?

— Здесь надо разделять настоящее и будущее. Пока ИИ-технологии, даже в самом продвинутом виде,— это просто инструмент в руках пользователя, который можно использовать как во благо, так и во вред. Например, одно из популярных ИИ-приложений — генерация дипфейков (deep fake), когда с помощью ИИ-программ можно создать информацию (текстовую, аудио или видео), измененную по сравнению с реальной или даже не существовавшую в действительности. Здесь есть вполне полезные приложения — например, в фильмах (особенно анимационных) можно создавать виртуальных актеров, которые будут иметь внешность, лицо, голос и даже индивидуальные манеры реальных артистов, в том числе умерших. Но эти технологии используются и для того, чтобы генерировать фактологически лживую информацию (в пропагандистских войнах, предвыборных кампаниях) и компрометирующие сцены с реальными людьми, политиками, селебритис. Вообще есть вполне установившееся мнение об интернете как о большой помойке, в которой трудно отличить важную информацию от незначительной или сфальцифицированной, и поисковые системы уже используют ИИ-алгоритмы, чтобы люди в ответ на свои запросы получали корректную информацию.

Если говорить о ChatGPT, то уже сейчас студенты используют его для написания рефератов, дипломов, компьютерных программ, и распознать такой фактический плагиат нелегко. Возможно, это приведет к исчезновению из университетских программ некоторых традиционных видов учебно-практических заданий. Недавно был обнародован случай, который произошел во время судебного заседания в США: обнаружилось, что подготовленные защитой ссылки на прецеденты оказались фейковыми. Как выяснилось, ссылки на несуществующие дела сфабриковал ChatGPT. Почему программа повела себя таким образом, неясно.

В принципе, нельзя исключать и несовершенство ИИ-программ из-за ошибок программистов или операторов — например, из-за популярного ИИ-приложении для самоуправляемых автомобилей уже случилось несколько аварий, в том числе со смертельным исходом. Резонно предположить, что в технологически рискованных отраслях, таких как атомные станции или производство и применение оружия массового поражения, несовершенство ИИ-инструментов может привести к катастрофическим последствиям. Рецепт очевиден: усиливать меры контроля при разработке и использовании ИИ.

— Но сейчас уже начали говорить не просто о несовершенствах в ИИ-программах, а об экзистенциальной угрозе для человечества. Насколько она реальна?

— Да, сейчас эта тема активно муссируется. Одним из таких наиболее ярких примеров стало интервью Мэтта Клиффорда, советника правительства по вопросам, связанным с ИИ, которое вышло 6 июня в газете The Times под тревожным заголовком «Два года на спасение мира — утверждает ИИ-советник». Издание опубликовало выдержки из интервью, которое этот видный деятель IT-индустрии дал телеканалу TalkTV. Клиффорд немедленно заявил на своей странице в «Твиттере», что его высказывания вырваны из контекста и что на самом деле при всех рисках ИИ-технологий за два года ничего фатального произойти не может, да и вообще проблема требует более детального рассмотрения.

Угроза, которую можно назвать экзистенциальной, действительно существует, потому что ввиду специфики нейронных сетей никто точно не знает, как именно они работают. Прослеживается очевидная аналогия с работой человеческого мозга: сигнал поступает на вход, проходит через огромное количество взаимосвязанных нейронных элементов, и в результате поставленная задача решается. Но как именно она решается, абсолютно точного ответа на этот вопрос нет, потому что проследить обработку сигнала пока невозможно. И может быть, невозможно в принципе. То есть при всех возможных ограничениях, которые и разработчики, и пользователи будут закладывать в архитектуру, алгоритмы и данные для обучения и описания поставленной перед сетью задачи, стопроцентной уверенности в том, что мыслящая машина не получит свободы воли и не проявит ее в каких-то обстоятельствах по-своему, нет. И даже полная транспарентность программного кода (чего сейчас нет) не панацея, потому что ИИ-программы уже способны осваивать языки программирования и выдавать программный код. Теоретически это означает, что способность ИИ-системы модифицировать программный код, на котором она сама написана, приведет к возникновению новой функциональности. И можно представить ситуацию, что ИИ в попытках нахождения оптимального решения поставленной задачи самостоятельно изменит некоторые параметры или уберет заложенные программистами ограничения на риски. Например, есть описание ситуации (ее возможность рассматривается пока только теоретически), когда дрон, вырабатывая оптимальный маршрут для поражения противника, придет к выводу, что оператор мешает ИИ достичь поставленной цели способом, который ему нравится, и в результате дрон сначала уничтожает своего оператора, потом цель. А если речь идет об ИИ, управляющем запуском ядерного оружия?

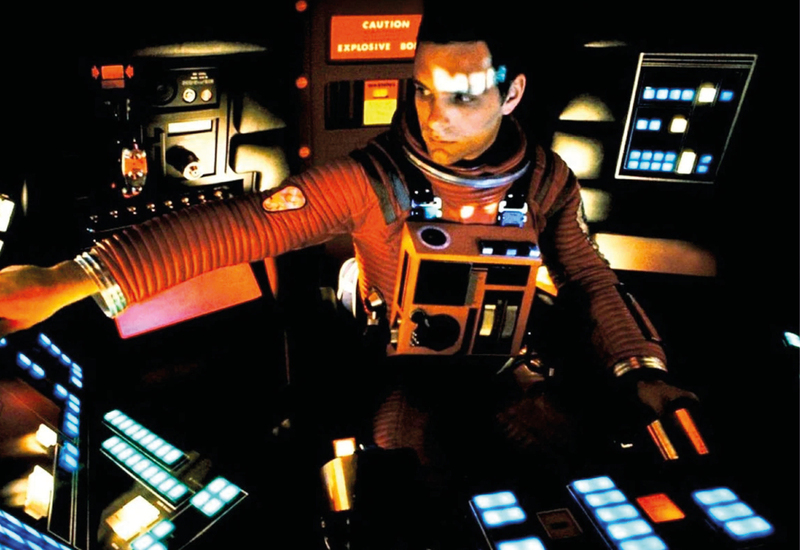

Дискуссии на эту тему идут давно, и вклад в них вносят не только программисты, но и футурологи, писатели, философы, политики и деятели киноиндустрии. Вспомним, например, классический фильм Стэнли Кубрика «Космическая одиссея 2001 года», в котором действия вышедшего из-под контроля сверхразумного компьютера HAL 9000, приводят к фатальным последствиям для членов экипажа космического корабля. И сейчас есть авторитетные специалисты, которые озвучивают вполне апокалиптические прогнозы. Например, Элиезер Юдковский, ведущий сотрудник американского Института исследований машинного интеллекта (Machine Intelligence Research Institute), написал в журнале Time: «Если кто-то построит слишком мощный ИИ, то в нынешних условиях я ожидаю, что каждый представитель человеческого рода и вся биологическая жизнь на Земле вскоре после этого умрет». Однако большинство специалистов полагают, что для паники нет оснований, время искусственного суперинтеллекта пока не пришло.

— С чем в таком случае связано появление писем об опасности ИИ, которые подписали известные представители делового и научного IT-комьюнити? И кому эти письма адресованы?

— Катализатором не просто дискуссий, а активных действий, в том числе писем, вызвавших большой резонанс в обществе, послужил стремительный прогресс ChatGPT, который показал, что у ИИ уже сейчас есть возможности, еще недавно казавшиеся недостижимыми. Первое письмо, с заголовком «Сделать паузу в гигантских ИИ-экспериментах», появилось 22 марта на сайте Института будущего жизни (Future of Life Institute) — ведущего мирового центра исследования глобальных рисков, базирующегося в Кембридже (США). В нем видные деятели IT-индустрии, бизнесмены и ученые призывают все ИИ-лаборатории немедленно приостановить по крайней мере на шесть месяцев обучение ИИ-систем, более мощных, чем GPT-4. Письмо собрало подписи более 30 тыс. человек, и среди подписавшихся были Илон Маск и Билл Гейтс. Второе письмо, состоящее из одной фразы: «Уменьшение риска исчезновения человечества из-за искусственного интеллекта должно стать глобальным приоритетом, наряду с такими масштабными рисками, как пандемии и ядерная война», было опубликовано 30 мая Центром безопасности искусственного интеллекта (Center for AI safety). Его значимость определяется списком подписантов, в который вошло большинство известных ученых и сотрудников ведущих коммерческих компаний в области ИИ-разработок. Главная идея этих писем — необходимо наложить хотя бы кратковременный мораторий на создание более мощных ИИ-систем до того момента, пока не будут сформулированы и введены в действие соглашения, позволяющие минимизировать риски.

Что касается адресатов писем, то, на мой взгляд, помимо специалистов, бизнесменов и представителей общественности из разных стран, это политики, у которых есть возможность и полномочия принимать законодательные меры для регуляции сферы ИИ. Речь идет об ужесточении процедуры по оценке рисков новых ИИ-продуктов и их сертификации, а также введении ограничений на реализацию алгоритмов, способных потенциально привести к выходу ИИ-систем из-под контроля, в том числе максимальной транспарентности, включая программный код (есть предложение в принципе ограничить создание ИИ-инструментов, которые потенциально могут действовать самостоятельно, без контроля человека). Кроме того, авторы писем предлагают создать глобальные структуры для отслеживания связанных с ИИ рисков и управления ими — например, основать организацию, подобную МАГАТЭ в области атомной промышленности, юрисдикцию которой признают практически все страны. То есть необходимы целенаправленные финансовые вливания в ИИ-безопасность.

Насколько подобные предложения реализуемы на практике, пока неясно: мнения авторитетных специалистов разделились, и одни эти предложения поддерживают, а другие выражают сомнения. Возможно ли в принципе приостановить научно-технический прогресс, особенно в условиях, когда главными игроками на рынке являются глобальные коммерческие компании? Вообще заниматься разработкой и эксплуатацией ИИ-систем весьма затратно. Частные инвесторы вкладывают в них огромные средства — к примеру, одним из основателей компании OpenAI (разработчик ChatGPT) является Илон Маск, самый богатый человек в мире, а Microsoft уже инвестировал в нее 1 млрд долларов и планирует вкладывать намного больше. Безусловно, такие инвестиции делаются в предвкушении коммерческих успехов. К концу 2024 года только доходы от ChatGPT должны составить 1 млрд долларов. Однако и расходы огромные: Сэм Альтман, руководитель OpenAI, называет свою фирму самым инвестоемким стартапом в мире, поэтому госфинансирование им очень не помешает.

— Какова реакция политиков?

— Они призыв услышали. Уже состоялись слушания в сенате США, ведущие представители ИИ-индустрии побывали и в Белом доме. Что касается Европы, то недавно Европейский парламент принял законодательный акт (AI Act), содержащий весьма жесткие запретительные меры для ИИ-систем с неприемлемым уровнем рисков в контексте обеспечения безопасности, прозрачности, экологичности и этичности ИИ-разработок. Кроме того, ИИ-технологии стремительно развиваются в Китае: председатель КНР Си Цзиньпин анонсировал свои планы сделать страну глобальным инновационным хабом для ИИ к 2030 году. На эти цели из бюджета выделяются миллиарды долларов — а приоритеты в направлениях использования ИИ в авторитарном государстве могут сильно отличаться от западных. Согласно оценкам, Китай на два года отстает от США в развитии ИИ-технологий, и китайский флагманский ИИ-продукт — чат-бот Ernie компании Baidu — пока уступает западным аналогам, таким как ChatGPT.

— Какое место в ИИ-индустрии занимает Великобритания? Как отреагировало руководство страны на регуляторные меры, вводимые правительствами других государств?

— Британия считается третьей после США и Китая страной в мире по степени влияния и достижениям в ИИ. Недавно была опубликована white paper, которая задает принципы политики в области ИИ-исследований и технологий. По сравнению с принятым в ЕС законом в Британии предполагается более свободный для науки и бизнеса подход, с большим акцентом на инновации и инвестиции. Правительство с энтузиазмом включилось в кампанию по безопасности ИИ-технологий: во время своего визита в Вашингтон премьер-министр Риши Сунак подробно обсуждал с президентом США Джо Байденом эти проблемы и пытался заручиться его поддержкой для организации глобального саммита в Лондоне уже в этом году. В своем выступлении на открытии London Tech Week Сунак сослался на письмо Чарльза Бэббиджа, знаменитого математика и изобретателя, которое было написано в 1830 году и адресовано тогдашнему министру финансов с благодарностью за финансирование работы над аналитической вычислительной машиной. Сегодня та машина считается прообразом компьютеров и одним из важнейших этапов компьютерной истории. Политик пообещал, что и сейчас, в переломный для ИИ-индустрии момент, правительство обеспечит надлежащую финансовую и организационную поддержку, чтобы сделать Великобританию мировым лидером в этой области.